Resenha: O cérebro relativístico: como ele funciona e porque não pode ser simulado por uma máquina de Turing.

Em 2018, durante a disciplina Teoria da Ciência 3 ministrada pelo professor Pinguelli Rosa, cotejei o que foi apresentando das ideias de Penrose, principalmente a questão da possibilidade ou não da simulação do cérebro humano, com outro trabalho publicado alguns meses antes, intitulado O cérebro relativístico: como ele funciona e porque não pode ser simulado por uma máquina de Turing, monografia escrita pelo neurocientista Miguel Nicolelis e pelo matemático Ronald Cicurel.

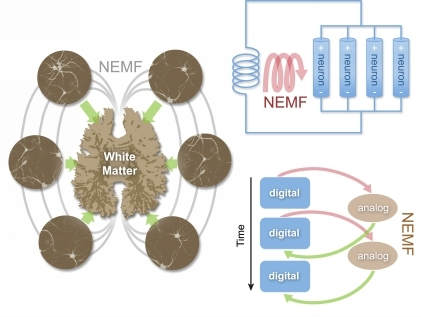

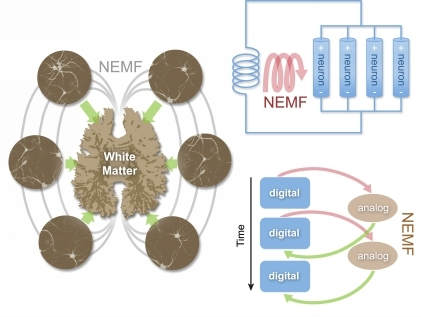

Os autores apresentam duas teses principais. A primeira delas “diz respeito a uma nova teoria abrangente sobre como cérebros complexos como o nosso funcionam. Batizada como Teoria do Cérebro Relativístico (TCR)”, ela se constitui de um novo modelo neurofisiológico que enxerga na articulação entre diferentes redes neuronais a conformação de um espaço tempo neural que se comunica através de “bobinas biológicas formadas por feixes de nervos que definem a substância branca, gerando campos eletromagnéticos neurais”. A deformação desse espaço mental seria a explicação de moléstias neurológicas e psiquiátricas.

A segunda tese dos autores é uma refutação, a partir do seu modelo, da possibilidade de uma inteligência artificial forte resultante da simulação dos processos cerebrais por máquinas universais de Turing. Isso porque a interação entre esses campos eletromagnéticos neuronais atua de forma analógica, não podendo ser completamente inscrita em algoritmos.

O primeiro capítulo, Registrando Populações de Neurônios e construindo Interfaces Cérebro-Máquina: o caminho experimental para desvendar o segredo do cérebro relativístico relata o trabalho de Nicolelis no desenvolvimento do método conhecido como registros crônicos com múltiplos eletrodos que “proporcionou a coleta de grandes quantidades de dados favorecendo a noção que populações de neurônios definem a verdadeira unidade funcional do cérebro dos mamíferos.”

Com base na tecnologia desenvolvida, Nicolelis e Chapin criaram um novo paradigma experimental chamado interfaces cérebro-máquinas (ICMs), a base do projeto Andar de Novo.

Para Nicolelis a evidência colhida sugere que “a mesma combinação de neurônios corticais nunca é repetida na produção do mesmo tipo de movimento”. Ou seja, os processos cerebrais não são redutíveis a uma conexão entre neurônios.

| TABELA 1 – Princípios da Fisiologia de Populações Neurais | ||

| Princípios | Explicação | |

| Processamento distribuído | A representação de qualquer parâmetro comportamental é distribuido por populações de neurônios e áreas cerebrais | |

| Insuficiência do neurônio único | Neurônios individuais são limitados na capacidade de codificar parâmetros comportamentais | |

| Multi-tarefa | Um mesmo neurônio pode participar na codificação de múltiplos parâmetros | |

| Efeito de massa neuronal | O logaritmo do # de neurônios corticais incluídos numa população determina a capacidade de codificação comportamental dessa população. | |

| Redundância | O mesmo comportamento pode ser produzido por diferentes populações de neurônios. | |

| Plasticidade | Populações neurais se adaptam constantemente a novas estatísticas do mundo externo | |

| Conservação de disparos | A taxa global de disparos de uma população de neurônios permanece constante durante o aprendizado ou execução de um comportamento | |

| Contextualização | As respostas sensoriais evocadas de populações neurais mudam de acordo com o contexto da tarefa e da geração do estímulo sensorial |

TABELA 1 – Publicado com permissão Nature Publishing do original de Nicolelis MAL e Lebedev MA. Nature Review Neuroscience 10: 530-540, 2009.

Para os autores, suas descobertas invalidam o paradigma dominado “por conceitos espaciais, como colunas e mapas corticais, e a sistemática e interminável descrição de propriedades peculiares de alguns tipos de neurônios”. Ao contrário:

“…do ponto de vista fisiológico, e em contraste direto com o clássico cânone da neuroanatomia cortical do século XX, não existem bordas espaciais absolutas ou fixas entre as áreas corticais que ditam ou restringem o funcionamento do córtex como um todo. Ao contrário, o córtex deve ser tratado como um formidável, mas finito, continuum espaço-temporal. Funções e comportamentos são alocados ou produzidos respectivamente por meio do recrutamento particular desse continuum de acordo com um série de restrições, entre as quais se encontram a história evolutiva da espécie, o layout físico do cérebro determinado pela genética e pelo processo ontológico, o estado da periferia sensorial, o estado dinâmico interno do cérebro, restrições do corpo que contém o cérebro, o contexto da tarefa, a quantidade total de energia disponível para o cérebro e a velocidade máxima de disparo de um neurônio.”

Para essa teoria:

“…quando confrontado com novas formas de obter informação sobre a estatística do mundo que o cerca, o cérebro de um indivíduo assimila imediatamente essa estatística, da mesma forma que os sensores e as ferramentas utilizadas para obtê-la. Desse processo resulta um novo modelo neural do mundo, uma nova simulação neural da noção de corpo e uma nova série de limites ou fronteiras que definem a percepção da realidade e do senso do eu. Esse novo modelo cerebral será testado e remodelado continuamente, por toda a vida desse indivíduo. Como a quantidade total de energia que o cérebro consome e a velocidade máxima de disparo dos neurônios são fixas, propõe-se que, durante a operação do cérebro, tanto o espaço como o tempo neural são relativizados de acordo com essas constantes biológicas”.

Os autores propõem um mecanismo através do qual emergeria esse continuum espaço-temporal, que eles descrevem no segundo capítulo A Teoria do Cérebro Relativístico: seus princípios e predições. Neste eles descrevem a geração, processamento e armazenamento de informações pelo sistema nervoso complexo de um sistema computacional híbrido digital-analógico, cujo componente digital é definido pelos potenciais de ação produzidos pelas redes de neurônios, algo já conhecido. A novidade proposta pelos autores é o componente analógico formado pela “superimposição de campos eletromagnéticos neurais gerados pelo fluxo de cargas elétricas pelos múltiplos feixes circulares de nervos que formam s substância branca do cérebro”.

A medição dos campos magnéticos corticais é algo rotineiro (através da magnetoencefalografia), mas os autores propõem a existência de campos subcorticais, mais fracos e de detecção mais difícil. Não existe ainda detecção desses campos subcorticais, mas evidências indiretas, como o estabelecimento de oscilações neuronais síncronas coerentes e disseminadas com mecanismos ainda não descritos.

Uma visão mais ativa do papel do cérebro na percepção dá base para o que os autores chamam de ponto de vista do cérebro, um estado que se vale da “experiência acumulada ao longo de toda a vida do indivíduo” que permite que o cérebro “esculpa e atualize continuamente esse “ponto de vista” interno, o qual pode ser interpretado como um modelo interno da estatística do mundo ao seu redor e do senso ser de cada um de nós”. Assim, o “cérebro vê antes de enxergar’, tendo um papel ativo na percepção. Isso permite a plasticidade que as máquinas não exibem. Ele cita o exemplo de ratos com implantes corticais que aprenderam a sentir a luz infravermelha (invisível para eles) como um novo sentido de tato.

Esta seria uma solução para o problema de ligação (binding problem), ou de como diferentes sistemas cerebrais se fundem na consciência. Segunda esta teoria, o cérebro não precisa reconstruir a imagem original do mundo exterior a posteriori, pois este já construiu uma hipótese analógica do que ele espera ver (expectativa a priori codificada nessa comunicação analógica). Para os autores isso torna seu sistema incompatível com um modelo computacionalista e digital do cérebro.

Experimentos com ratos demonstram que na iminência do contato com um objeto (mas antes do mesmo) há uma atividade neuronal antecipatória que precede o contato por centenas de microssegundos.

Essa teoria explicaria diferenças na esfera sensorial entre animais anestesiados, despertos e imóveis ou ativos, o que corresponderia a diferenças nos estados dinâmicos internos do cérebro. É importante para eles o conceito de imagem do corpo, permanentemente atualizada, que fica em evidência com os relatos das sensações em membros fantasmas (amputados), ou no experimento da mão de borracha. Esse mecanismo analógico também estaria implicado na sensação de dor que não pode ser recriada estimulando o córtex. Os sonhos seriam exemplos de computações analógicas criadas para, entre outras coisas, estocar memórias a nível cortical.

Existe uma argumentação matemática contida nessa teoria, que envolve a análise da geometria e da topologia desse “espaço mental, que define um continuum multidimensional”. Para os autores, os efeitos de drogas alucinógenas que modificam as percepções de tempo e espaço sugerem que o espaço mental seria mais Riemanniano que euclidiano.

Isso explica como o cérebro é capaz de recrutar áreas corticais para o processamento de informações táteis no caso de pessoas cegas, ou mesmo sua capacidade de acessar memórias de forma instantânea. De acordo com essa visão doenças mentais são uma “dobradura” inapropriada do continuum espaço-temporal.

No terceiro capítulo, A disparidade entre sistemas integrados como o cérebro e uma máquina de Turing os autores criticam o computacionalismo. Eles consideram, citando outros filósofos, como “‘puramente mística’ a visão que funções mentais superiores, envolvendo linguagem, tomadas de decisão e raciocínio possam, de alguma forma, ‘emergir das interações de comportamentos básicos”.

A ideia da complexidade é apresentada como um impedimento da possibilidade de simulação, pois “seria preciso incluir na definição de complexidade deste cérebro todas as suas interações com entidades externas, com o ambiente que o cerca e com os cérebros de outros indivíduos da sua espécie”.

A complexidade do sistema impediria que a infinidade de eventos interativos entre moléculas e circuitos que leva a propriedades emergentes não poderia ser simulado.

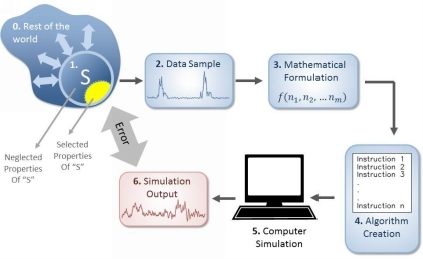

No quarto capítulo Os argumentos matemáticos e computacionais que refutam a possibilidade de simular cérebros numa máquina de Turing, os autores seguem na mesma linha de Penrose. A dificuldade da simulação de qualquer sistema físico é ilustrada pelo argumento de Michael Berry, sobre a tentativa de simular os sucessivos impactos de uma bola de bilhar num jogo, conhecendo completamente as condições iniciais. Calcular o que acontece durante o primeiro impacto é simples, mas, “para computar o nono impacto, é preciso levar em consideração o efeito gravitacional de alguém posicionado próximo à mesa de bilhar. E para computar o quinquagésimo sexto impacto, cada partícula individual de todo o universo precisa fazer parte das suas suposições; um elétron, no outro lado do universo, deve participar desses nossos cálculos’.

Os autores reconhecem que o próprio pai da computação, Turing, já reconhecia essa limitação, e por isso pensou num modelo mais poderoso que as Máquinas de Turing, campo hoje conhecido como hipercomputação. A solução de seu artigo de 1939 foi a introdução da figura do oráculo, capaz de resolver uma função arbitrária.

O capítulo segue relatando o trabalho de Chaitin, da Costa e Dória (Chaitin, da Costa et. al. 2011), bem como outros autores (Pour-El e Richards 1989), que propuseram a ideia que “sistemas analógicos, não os digitais, podem decidir algumas sentenças matemáticas não solucionadas”. Isso aconteceria porque mecanismos computacionais analógicos “computam fisicamente”, ou seja, eles computam simplesmente por obedecer às leis da física, ao invés de através de um algoritmo pré-formulado dentro de um sistema formal, criado para solucionar equações que têm a intenção de descrever o comportamento de um sistema. Colocado de outra forma, nos computadores analógicos não existe a separação entre “hardware” e “software”, porque a configuração do “hardware” desse computador está encarregada de realizar todas as computações necessárias e ainda modificar a si mesmo.

No quinto capítulo, O argumento evolucionário, os autores partem do experimento mental do Filme da Vida proposto por Stephan Jay Gould. Rebobine a fita da história de toda a vida na terra, e aperte o play, e você assistirá um filme diferente, que não resultaria no surgimento da espécie humana ao final.

Para os autores, isso prova que não é possível fazer engenharia reversa de algo que não foi construído. A quantidade de eventos aleatórios envolvidos em um processo destes, extremamente complexo, impediria que uma simulação pudesse repeti-lo.

No sexto capítulo, O cérebro humano como um sistema físico muito especial: o argumento da informação, os autores diferenciam dois tipos de informação, de tipo 1 e de tipo 2, respectivamente, informação extrínseca, de Shannon e Turing, e informação extrínseca, de Gödel. Se uma foto for mostrada para uma pessoa, pode-se mensurar a atividade elétrica do cérebro dessa pessoa e obter-se informação de tipo 1, enquanto que se perguntarmos como a pessoa se sentiu, obteríamos informação de tipo 2, que seria acessível apenas a partir do ponto de vista interno do cérebro.

Na conclusão os autores explicitam suas discordâncias com outras teorias. Citam o exemplo de Christopher Koch, diretor científico do Instituto Allen De Neurociência, que defendeu que a consciência pode emergir de qualquer sistema de informação suficientemente complexo, tendo declarado que: “Da mesma forma, eu proponho que nós vivemos num universo de espaço e tempo, massa, energia e consciência, emergindo de sistemas complexos”. Koch se refere a uma função designada como ϕ por Giulio Tononi (Tononi 2012) e que mede, em bits, a quantidade de informação gerada por um conjunto de elementos, acima e além da informação gerada pelos seus componentes. Koch propõe que ϕ oferece uma medida de consciência. Os autores, por outro lado, acreditam que “a complexidade é uma condição necessária, mas não suficiente, para gerar informação Gödeliana, e consequentemente, uma entidade consciente”. Para eles, “ϕ continua sendo uma medida de informação Tipo I (Shannon-Turing) e, como tal, imprópria para justificar o surgimento de funções cerebrais superiores responsáveis por fundir, em uma única imagem, o fluxo contínuo de informação sensorial e mnemônica”. A consciência humana só pode “emergir como consequência de uma “escultura evolucional” que lapidou e definiu a configuração física do cérebro”.

Eles concluem afirmando que Finalmente, nós gostaríamos de dizer que, de forma alguma, nós estamos sugerindo que funções cerebrais superiores não poderão um dia ser reproduzidas artificialmente. Essencialmente, nós simplesmente explicitamos uma série coerente de argumentos que demonstram que, se e quando isso acontecer, esse evento não será produto de uma máquina de Turing, não importa quão sofisticada e poderosa ela possa ser.

Comentários