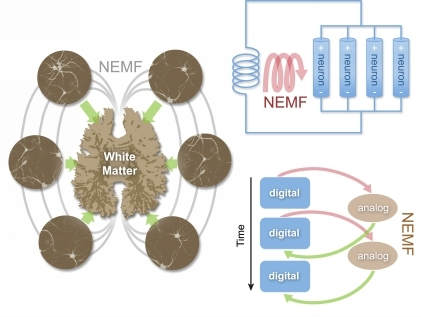

Resenha: O cérebro relativístico: como ele funciona e porque não pode ser simulado por uma máquina de Turing.

Em 2018, durante a disciplina Teoria da Ciência 3 ministrada pelo professor Pinguelli Rosa, cotejei o que foi apresentando das ideias de Penrose, principalmente a questão da possibilidade ou não da simulação do cérebro humano, com outro trabalho publicado alguns meses antes, intitulado O cérebro relativístico: como ele funciona e porque não pode ser simulado por uma máquina de Turing, monografia escrita pelo neurocientista Miguel Nicolelis e pelo matemático Ronald Cicurel. Os autores apresentam duas teses principais. A primeira delas “diz respeito a uma nova teoria abrangente sobre como cérebros complexos como o nosso funcionam. Batizada como Teoria do Cérebro Relativístico (TCR)”, ela se constitui de um novo modelo neurofisiológico que enxerga na articulação entre diferentes redes neuronais a conformação de um espaço tempo neural que se comunica através de “bobinas biológicas formadas...

Automação e inteligência artificial

Como frisamos, a divisão proposta por Bevilaqua da Revolução Industrial em três fases, derivadas da análise de Marx dos três mecanismos que compõem o sistema de máquinas, admite a existência de sobreposições temporais, como a invenção de Joseph-Marie Jacquard, um pioneiro da automação que construiu, ainda em 1801, um tear programável através de cartões perfurados. Este trabalho é fundamental para a posterior criação dos computadores, da mesma forma que os trabalhos teóricos sobre as máquinas analíticas e algoritmos por Charles Babbage e Ada Lovelace, realizados ainda no século XIX (BEVILAQUA, 2015, p. 277 e 278). O fato dos primeiros computadores comercializados terem sido construídos no final da Segunda Guerra Mundial, com base na solução proposta por Alan Turing ao “problema da decisão, Entscheidungsproblem, proposto por David Hilbert como um desafio em 1928”, é uma demonstração de...

Superbactérias: ficção científica ou mazela do capitalismo?

A humanidade enfrenta problemas cada vez mais complexos e globais, que emergiram com a revolução industrial e a forma com a qual o capitalismo levou ao extremo sua visão unilateral de aplicação da ciência. Um Relatório Global da OMS (Organização Mundial da Saúde), intitulado “Resistência Antimicrobiana”, trouxe a atenção da mídia para um problema ecológico global com um potencial catastrófico para a humanidade comparável ao do aquecimento global. O prefácio do texto, assinado pelo Dr Keiji Fukuda, afirma taxativamente: “Uma era pós-antibióticos, na qual infecções comuns e pequenos ferimentos podem matar, longe de ser uma fantasia apocalíptica, é na verdade uma possibilidade muito real para o século 21”. Estamos assistindo ao surgimento de cepas de bactérias totalmente resistentes a todo o tipo de medicação desenvolvida até então. Esse relatório traz à tona o caso de sete espécies de...

A revolução científico-técnica e a terceira fase da Revolução Industrial

Um século e meio após os estudos históricos de Marx e Engels, podemos perceber que se a primeira fase da Revolução Industrial, entre 1735 e 1840, é a parteira de um novo modo de produção, e uma segunda fase desta, entre 1848 e 19451, ao incorporar novas fontes de energia térmica à produção, é responsável pela expansão do sistema capitalista por todo o globo, sua terceira fase, iniciada no pós-guerra, e da qual somos contemporâneos, com a revolução dos mecanismos de transmissão e controle, a cibernética, ao permitir a automação da produção, leva o sistema capitalista a uma crise que se apresenta insuperável dentro dos marcos do sistema (BEVILAQUA, 2015). Como vimos anteriormente, se não podemos responsabilizar diretamente a produção científica, entendida em seu sentido mais estreito como corpo de conhecimento sistematizado e promovido a partir de instituições oficiais (universidades,...

A máquina-ferramenta e o início de um processo

Spinning Jenny Em famosa nota de rodapé em O Capital, Marx cita a história das espécies biológicas contada a partir de Darwin e lança o desafio da escrita de uma história da evolução dos projetos das máquinas, desestimando o papel dos inventores individuais, em favor das forças sociais e da luta de classes: “Uma história crítica da tecnologia provaria, sobretudo, quão pouco qualquer invenção do século XVIII cabe a um só indivíduo.” (MARX, 1996, l. 1, v. 2. p. 8). Marx, que como vimos era um dedicado estudioso do desenvolvimento tecnológico, adianta alguns pontos dessa história em um breve relato que ele apresenta para ilustrar sua análise econômica mais abrangente da transição da manufatura à grande indústria. Nesta obra, Marx confere papel preponderante no início da Revolução Industrial ao desenvolvimento da máquina-ferramenta. A máquina-ferramenta que ele também chama de máquina de...

A maquinaria, os órgãos sociais da produção subsumidos ao conceito de capital

Para entendermos o surgimento da indústria a partir do materialismo histórico, é necessário compreendermos o fato, demonstrado por Bevilaqua (2016), de que no método de Marx a máquina deve ser entendida como uma categoria econômica subsumida ao conceito de capital, o que contrasta com a abordagem mais histórico-descritiva de Rosenberg. Deve-se, primeiramente, entender o papel da máquina nas transformações ocorridas no processo de produção de valores de uso, um papel que a distingue da ferramenta, pois se ao longo de todo o período pré-industrial da história da humanidade era a força de trabalho o ponto de partida do revolucionamento do modo de produção, na grande indústria este ponto de partida está no meio de trabalho (MARX, 1996, Livro 1, v. 2. p. 8). Em contraste com a ferramenta e mesmo com a manufatura, o sistema de máquinas relativiza todos os limites impostos pela natureza do...

A ciência e a inovação no contexto do processo de produção de valor

A especificidade do processo de trabalho no modo de produção capitalista é que o processo de produção de valores de uso, objetos destinados à satisfação das necessidades humanas, conforma uma unidade dialética com o processo de produção de valor, mensurado através do quantum de trabalho social contido em cada mercadoria. Enquanto que a produção de valores de uso só é possível pelo caráter concreto do trabalho, o processo de produção de valor só faz sentido ao considerar-se o caráter abstrato do trabalho, justamente o que permite que as mais variadas atividades produtivas humanas possam ser comparadas e seus resultados intercambiados no mercado. Esta contradição histórica desenvolvida pela relação-capital, manifesta no duplo caráter do trabalho (concreto e abstrato) e que se expressa na ambiguidade da forma mercadoria (valor de uso e valor de troca) também se manifesta na produção...

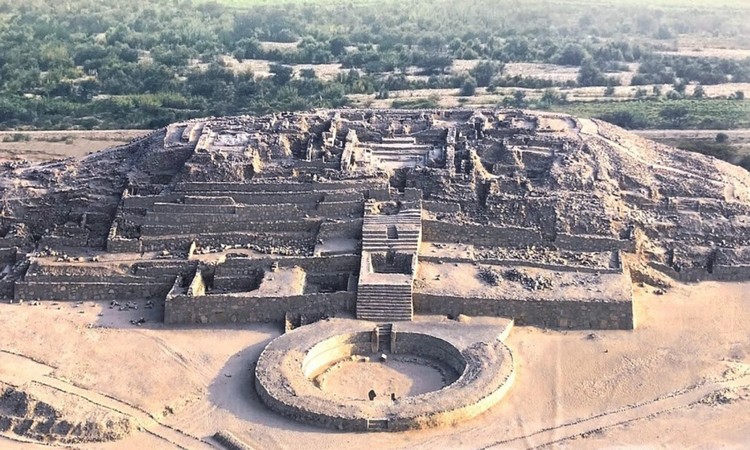

A Revolução Neolítica

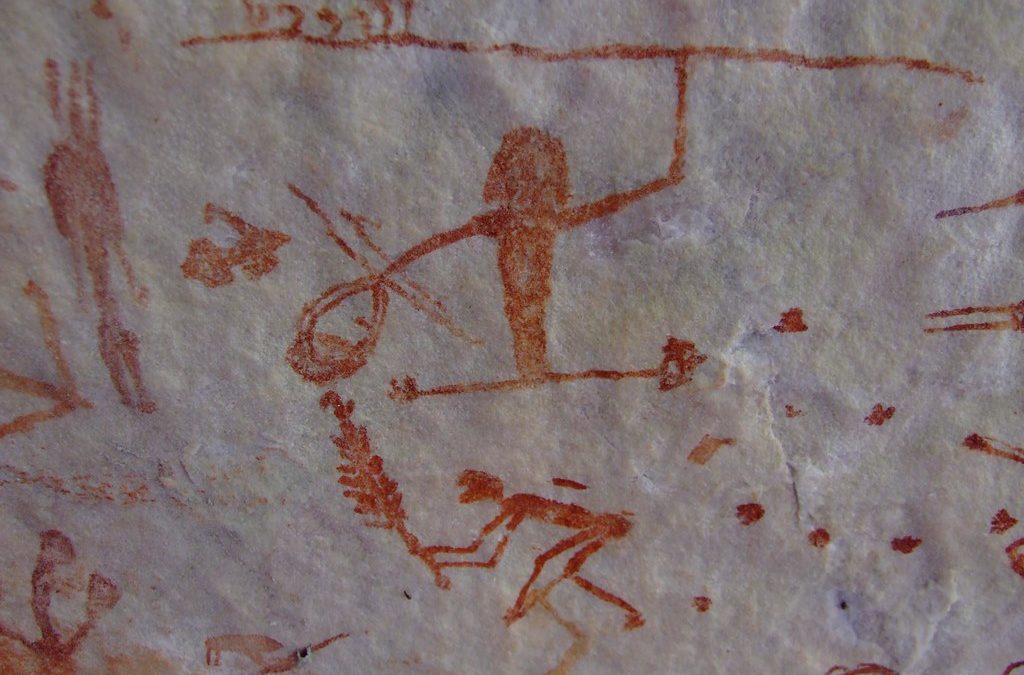

Caral, local da Revolução Neolítica nos Andes Se a produção de ferramentas, marco inicial do Paleolítico, está na base do processo de conformação biológica da nossa espécie, e, posteriormente, o surgimento do comportamento simbólico inicia a fase superior desse período, na qual o Homo sapiens (e os extintos neandertais) passam a exibir comportamentos que os distinguem de todos os seus ancestrais chamados de arcaicos, o Neolítico, iniciado há cerca de 11 mil anos, corresponde ao aparecimento da sociedade civil e da política, após a agricultura e a domesticação dos animais levarem à produção de excedente. A transformação radical na relação entre o homem e a natureza não se limitou, desta vez, à manipulação de objetos inanimados como pedras, metais e madeira: os seres humanos passaram a dominar outras espécies biológicas, principalmente ao controlarem o ciclo reprodutivo dessas. A...

O paleolítico e nossa criação a partir do trabalho

Podemos afirmar que o Paleolítico, periodização utilizada para definir a pré-história tecnológica humana, antecede e está na base do surgimento da nossa espécie biológica, resultado de milhões de anos de uso de ferramentas pelos primatas. Desta forma, nem a comunidade humana, nem sua sucessora neolítica, a sociedade de classes, como complexos dinâmicos de relações sociais entre homens e mulheres, podem ser compreendidas se nos restringirmos apenas à história do homo sapiens, a partir do processo de especiação que nos distinguiu de algumas variações do homo erectus há centenas de milhares de anos. Há algumas décadas, as descobertas paleontológicas identificam em hominídios já extintos, do gênero Homo ou não e que fazem ou não parte da nossa linha de ascendência, características que até então julgávamos únicas à nossa espécie, como a capacidade de confeccionar ferramentas. O...

As Revoluções do Neolítico, do Paleolítico e Industrial

Como já afirmamos, a identidade entre revolução industrial e capitalismo não permite afirmar que os avanços técnicos tenham sido inaugurados com este modo de produção. Como lembra Santos, um certo grau de desenvolvimento das forças produtivas já é um pré-requisito para o surgimento deste: O modo de produção capitalista surge num estágio bastante elevado da luta do homem para submeter a natureza. De fato, este modo de produção surge como consequência do alto desenvolvimento das forças produtivas devido à expansão das indústrias e do comércio mundial (SANTOS, 1983, p. 11) Esta correspondência entre revolução industrial e capitalismo pressupõe apenas “um novo patamar da relação entre o homem e a natureza, de forma análoga à objetivação do corpo humano nas ferramentas produzidas desde o paleolítico” (BEVILAQUA, 2015, p. 251). Engels, ao mesmo tempo que reconhece a importância da revolução...