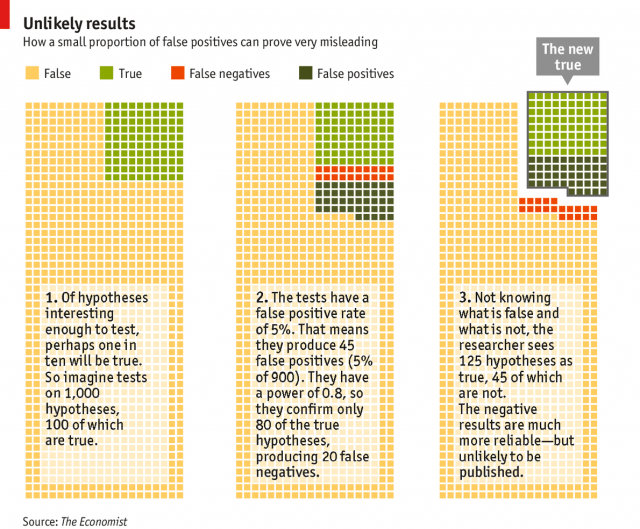

Pensemos, no seguinte problema: uma versão simplificada da simulação apresentada por Colquhoun (2014), cujo código fonte do script foi disponibilizado para reprodução.

Em um determinado campo, um total de mil hipóteses estão sendo investigadas. Estabelecemos arbitrariamente que, dentre essas, 100 refletem relações verdadeiras presentes na realidade, ainda que ninguém saiba quais sejam. Digamos que os experimentos, quando diante das hipóteses verdadeiras, identifiquem 80% delas. Neste caso, a taxa de falso-negativo β é de 20%. Imaginemos uma taxa de falso-positivo α mais baixa, de apenas 5%. Como temos um grande número de hipóteses falsas a serem testadas, o que é natural, descartamos corretamente 855 hipóteses falsas, mas geramos 45 falsos positivos.

A nova verdade estabelecida neste campo compreenderá 125 hipóteses alternativas, das quais mais de um terço é falsa. Desta forma, mesmo seguindo-se todos os procedimentos padrões, quase um terço das descobertas anunciadas são falsas.

Algumas soluções foram apresentadas por estatísticos para que esses enganos sejam sanados. Uma delas é a adoção de valores de p mais baixos, como é o caso da física de partículas, que adota o valor de p = 0.0000003, o que também é conhecido como cinco sigma.

Neste caso, os erros de falso positivo seriam muito mais raros do que quando se adota o p valendo 0.5. A probabilidade de que, com a hipótese nula verdadeira os resultados obtidos, ou outros mais extremos, teoricamente será de 1 em 3,5 milhões.

Comentários